STRANE COINCIDENZE

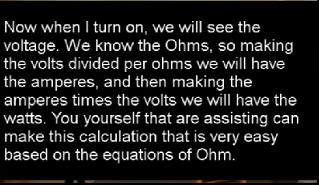

Nel 1969 venne pubblicato in Olanda il libro “Buitenaardse beschaving”. Quest’opera narra delle esperienze autobiografiche dell’ingegnere olandese Stefan Denearde, il quale rivela di aver vissuto incontri ravvicinati con esseri provenienti da un altro pianeta. Potrebbe sorgere la suggestione che il testo sia il frutto dell’ingegno straordinariamente fantasioso di uno scrittore di fantascienza. Tuttavia, va notato che il libro, concepito negli anni ’60, dettaglia con minuzia le tecnologie impiegate dalla razza extraterrestre degli Jarga, oltre a esporne la filosofia e la struttura sociale ed economica. In effetti, l’opera abbraccia elementi di anticipazione in ciascuno di questi ambiti.

Nel libro si parla in modo dettagliato di tecnologie che al tempo non potevano essere conosciute e che ancora oggi sono solo in fase di studio o ipotesi.

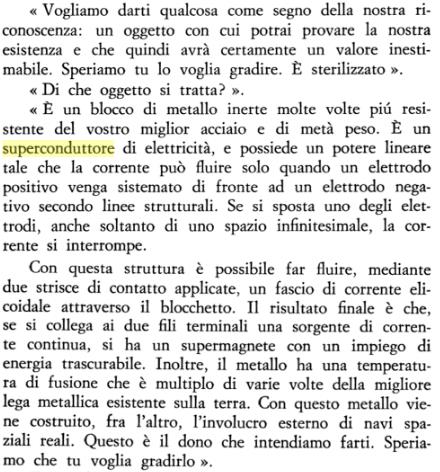

Una parte interessante riguarda l’episodio in cui l’extraterrestre che interagisce con Stefan gli fa dono di un pezzo di materiale che descrive come un materiale Superconduttore . Riporto la parte in questione :

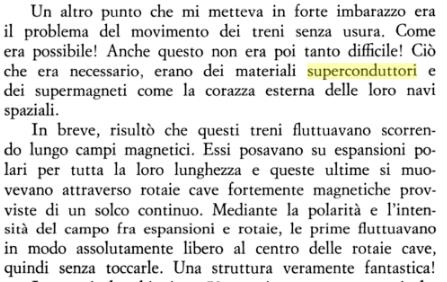

In seguito si parla di come questi superconduttori venivano usati non solo per la costruzione delle astronavi ma anche per la levitazione magnetica dei treni:

Questo libro è stato scritto 60 anni fa e ci parla della tecnologia dei superconduttori raccontandoci aspetti che ancora non abbiamo esplorato. E’ un libro che tutti dovrebbero leggere perchè ricco di spunti interessanti .

Ma ora torniamo ai giorni nostri, da fine luglio 2023 ci sono state varie pubblicazioni da parte di un gruppo di ricercatori Coreani i quali hanno presentato un materiale di loro produzione che presenta caratteristiche di superconduttività a temperatura ambiente.

E’ stato pubblicato anche il video di un frammento di questo materiale che mostra capacità di levitazione.

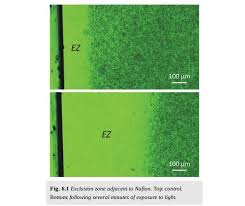

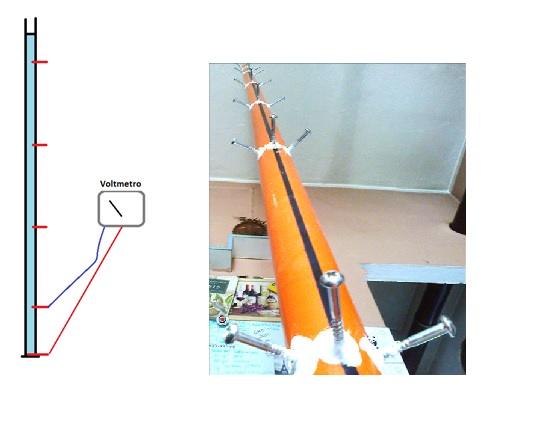

Vediamo le immagini del materiale superconduttore LK-99.

Si può vedere che il materiale non levita completamente. Quando lo muovono, si appiattisce, poi lo rimuovono e si vede che ruotato di 180 gradi fa lo stesso effetto. E’ come se ci fosse un asse di riferimento. Questo ricorda quanto dicono di Jarga,

Se diamo per buono quanto viene detto dagli Jarga sui superconduttori, sarà difficile che altri laboratori riescono a replicare in modo convincente l’esperimento. La creazione di un percorso superconduttivo per il momento sembra del tutto casuale,…

Il gruppo coreano ha ottenuto il materiale LK99 dopo innumerevoli tentativi. Non sarà una cosa cosi facile riuscire riuscire a ripetere l’effetto, quando solo raramente si crea un percorso superconduttivo e per di più esso esiste solo lungo una delle infinita rette passanti per l’oggetto. Va detto che gli autori erano già arrivati a vedere qualcosa tempo fa ma non erano stati validati in quanto il fenomeno era ancora più modesto di questo.

Difficile che altri ricercatori riescano in breve termine ad ottenere gli stessi risultati.

E’ probabile che i risultati non saranno omogenei o continuativi e tutto ciò aumenterà le domande e darà argomentazioni agli scettici.

Per il momento si è alzato il livello di interesse sulla questione in maniera sorprendente.

Vediamo cosa si dice sull’argomento

…

Come funzionano i superconduttori

Un superconduttore a temperatura ambiente autentico sarebbe una grande svolta, degna di entusiasmo. I materiali moderni che utilizziamo per condurre l’elettricità, come i fili di rame che alimentano la nostra casa, sono inefficienti. Mentre gli elettroni viaggiano lungo il filo, collidono con gli atomi del materiale, creando calore e causando perdita di energia. Questo fenomeno è noto come resistenza elettrica e fa sì che fino al 10% dell’elettricità venga dispersa mentre viaggia lungo le linee di trasmissione verso le abitazioni. Anche nei nostri dispositivi elettronici si verifica una perdita di energia.

Ma se i fili e le linee di trasmissione fossero realizzati con un materiale superconduttore, queste perdite potrebbero essere praticamente azzerate. Gli elettroni si accoppiano mentre attraversano il materiale e non urtano così tanto gli atomi, permettendo loro di fluire liberamente.

I materiali superconduttori esistono già e vengono utilizzati in diverse applicazioni, come le macchine a risonanza magnetica (MRI), in tutto il mondo. Tuttavia, questi materiali richiedono temperature estremamente basse (avvicinandosi allo zero assoluto a circa meno 459 gradi Fahrenheit) o pressioni estremamente elevate (oltre 100.000 volte la pressione atmosferica).

Nel frattempo, un sistema di levitazione magnetica superconduttiva sta venendo costruito dalla Central Japan Railway per trasportare passeggeri tra Tokyo e Nagoya. Il treno SCMaglev utilizza ruote in gomma per raggiungere velocità di circa 93 miglia all’ora prima che il sistema magnetico superconduttivo prenda il controllo. Dovrebbe essere in grado di raggiungere velocità di 311 miglia all’ora.

Il processo richiede una lega di niobio-titanio superconduttiva, raffreddata a meno 452 gradi Fahrenheit con elio liquido.

Un superconduttore a temperatura ambiente come LK-99 renderebbe quest’impresa molto più economica e eviterebbe la necessità di accumulare elio. (Nonostante alcune preoccupazioni dei media negli ultimi anni, l’elio non sta finendo, ma è prodotto solo in pochi paesi, quindi problemi di approvvigionamento possono causare enormi aumenti di prezzo.)

….

E ora, cosa succederà per LK-99?

Al momento, probabilmente non molto per te, a meno che tu non voglia tuffarti in un tunnel di fisica su X( il nuovo nome di twitter) e lasciarti coinvolgere nel momento. Neanche nel prossimo futuro, forse.

Siamo ancora alle prime fasi della replica degli esperimenti su LK-99, ma le cose non sembrano andare molto bene. Due studi pubblicati su arXiv lunedì da due gruppi di ricerca separati non sono stati in grado di replicare la ricerca sudcoreana. Alcuni comportamenti di superconduttività del materiale sono stati osservati in campioni molto piccoli da ricercatori cinesi, ha notato Wang.

La scienza è generalmente un processo lento. La conferma del lavoro del team sudcoreano era prevista in una settimana, ma con l’entusiasmo già alle stelle, gli studi teorici si sono affrettati a cercare di spiegare le caratteristiche di LK-99.

Sinéad Griffin, una fisica presso il Lawrence Berkeley National Laboratory, ha fornito un’analisi delle capacità di LK-99 utilizzando simulazioni di supercomputer. (Il post di Griffin su X era accompagnato da un meme di Barack Obama che lasciava cadere il microfono.) Questo studio è stato anche pubblicato su arXiv come preprint.

I fisici che hanno commentato il lavoro di Griffin si sono mostrati cinici riguardo al meme del microfono lasciato cadere e non sono stati convinti che quanto pubblicato fornisse una prova solida della superconduttività. La stessa Griffin ha chiarito i suoi risultati in un thread su X mercoledì, affermando che non dimostravano né fornivano prove di superconduttività nel materiale, ma mostravano interessanti proprietà strutturali ed elettroniche che hanno caratteristiche comuni con i superconduttori ad alta temperatura (cioè, molto al di sopra di meno 452 Fahrenheit, ma molto, molto al di sotto della temperatura ambiente).

Anche se LK-99 si dimostrasse un materiale superconduttore affidabile, tradurre la scienza in tecnologia potrebbe richiedere un processo ancora più lento. Produrre in modo affidabile il materiale potrebbe richiedere molti anni, e il lavoro teorico di Griffin mostra anche che potrebbe essere difficile sintetizzare il materiale.

LK-99 non sembra essere il Santo Graal, ma potrebbe essere un materiale interessante di per sé, aprendo possibilità di ricerca di superconduttori a temperatura ambiente in nuovi modi imprevisti. Se portasse a un superconduttore a temperatura ambiente, allora le possibilità si aprirebbero davvero.

Giuseppe Tettamanzi, docente presso la School of Chemical Engineering dell’Università di Adelaide, nota che da molto tempo gli scienziati stanno pensando di sostituire i cavi di rame della rete elettrica con cavi superconduttori, un cambiamento che potrebbe portare a enormi risparmi energetici. Egli menziona anche i benefici per i computer quantistici e il trasporto.

“Qui il cielo è il limite”, ha detto.

Assistere alla scienza in azione è eccitante, e la passione per LK-99 è stato un bel cambiamento sul feed di X, almeno per me. Ma la scienza richiede tempo e non dovrebbe trarre conclusioni affrettate riguardo alle possibili ramificazioni di un materiale superconduttore potenziale. Ora attendiamo che vengano replicati gli esperimenti.

RIFLESSIONI PERSONALI SULL’ARGOMENTO .

Durante i miei anni di studio, uno dei testi che ho trovato più utili è stato un libriccino sul “Pensiero Laterale”. Si asseriva che il vero ricercatore NON deve solo seguire lo schema in cui è stato edotto dalla cultura sociale, deve “saltare” con ragionamenti fuori schema. Si citava come esempio Salmoiraghi inventore della macchina da cucire, egli trovò la soluzione quando pensò ad un ago in cui il foro per il filo invece di essere messo nel didietro era spostato in testa all’ago da cucire.

Essendo la superconduttività un fenomeno ancora non bene compreso è importante affrontare l’argomento con la massima apertura mentale per evitare di limitare la ricerca alle sole strade conosciute che limiterebbero la possibilità di sviluppare questa tecnologia.

Io immagino la superconduttività come la seguente situazione:

Pensiamo all’elettrone come ad un ragazzo che deve attraversare uno specchio d’acqua .

Il ragazzo per passare dall’altra parte dovrà necessariamente bagnarsi i piedi nell’acqua.

Possiamo considerare il fatto che il “bagnarsi i piedi” equivale al prezzo da per riuscire a passare nell’altra sponda.

In modo similare, le cariche elettriche che attraversano un filo conduttore, dovranno pagare un prezzo per arrivare dall’altra parte, il prezzo dipenderà della resistenza del filo in Ohm.

Supponiamo che lo specchio d’acqua che il ragazzo deve attraversare sia un torrente con dei sassi che sporgono sulla superficie e gli permettono di passare dall’altra parte saltando da un sasso all’altro. Se i sassi si trovano ad una distanza ragionevole l’uno dall’altro, il ragazzo riuscirà a compiere l’attraversamento senza bagnarsi (e quindi senza pagare pegno)

Pensiamo all’eventualità che mentre il ragazzo stà cercando di attraversare il torrente saltando da un sasso all’altro, intervengano degli agenti disturbatori : delle persone che cercano di spingerlo per farlo cadere in acqua..

a) Se il ragazzo riesce ad attraversare lo specchio d’acqua SENZA BAGNARSI siamo nel caso della superconduttività.

b) Se invece cade è costretto a muoversi nell’acqua verrà rallentato, e pagherà un prezzo in attrito ; questo prezzo da pagare corrisponde alla resistenza elettrica in Ohm.

Ora consideriamo delle cariche elettriche che devono attraversare un filo conduttore che va dal punto A al punto B

Le cariche elettriche possono trovare:

Molta difficoltà ad attraversarlo = alta resistenza (in caso di un materiale isolante o poco conduttivo)

Poca difficoltà ad attraversalo = bassa resistenza (se il materiale è un buon conduttore come l’ Argento o il Rame)

Nessuna difficoltà di attraversamento (superconduttori)

In natura i superconduttori sono rari, come succede per i torrenti che non sempre hanno la fortuna di avere dei “sassi come nel nostro esempio.

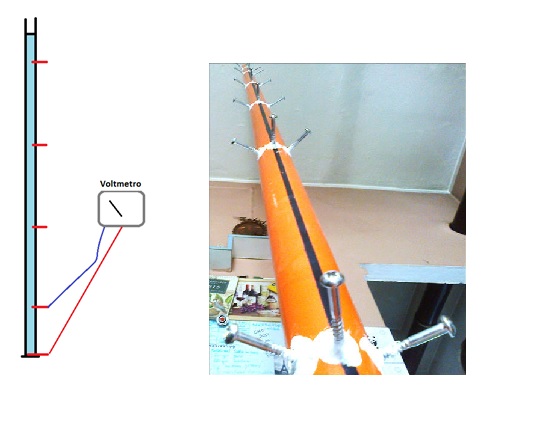

Per avere un superconduttore è necessario che la carica riesca a muoversi in linea retta e che non subisca “disturbi” laterali che modificano la sua traiettoria.

I disturbi laterali sono dovuti sia alle vibrazioni dell’elettrone che alle vibrazioni dell’ambiente circostante. corrispondono ad una sorta di “energia cinetica laterale” di disturbo. Gli atomi che affiancano il percorso dell’elettrone sono paragonabili a spinte laterali di varia intensità.

Le spinte laterali sono legati alla temperatura, più alta è la temperatura e più alta è l’agitazione (o viceversa).

Fino ad ora i superconduttori sono stati ottenuti limitando il “disturbo” con la riduzione dello spazio, e tramite l’abbassamento delle temperature e/o l’utilizzo di pressioni elevate.

Se fosse possibile trovare un altro sistema per eliminare l’agitazione laterale, le cariche potrebbero più facilmente attraversare il loro tragitto senza perdere energia (senza“ bagnarsi”) e dando superconduttività.

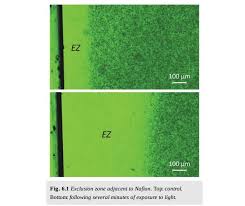

Quindi Il primo problema da risolvere è creare dei sassi sporgenti nell’acqua ma NON basta il secondo problema è l’eliminazione delle spinte laterali. Su questo argomento riporto questo stralcio:

…. Immaginiamo che un atomo sia un uomo. Poiché sappiamo che l’atomo si muove sempre, supponiamo di prendere un uomo che continuamente e così rapidamente si muova da impedirci di conoscere il suo viso.

In questo caso che si dovrebbe fare? Si prenderebbe forse questo uomo e si aumenterebbe il suo movimento per conoscerne il suo viso? No certamente. E allora perché gli studiosi hanno aumentato il movimento dell’atomo? In questo modo non potevano venire a conoscenza dell’atomo e neppure conoscere le esatte leggi fisiche fondamentali che lo governano.

Ritorniamo all’uomo che si muove sempre (che abbiamo supposto rappresenti l’atomo) e vediamo cosa si potrebbe fare per arrestarlo. Ci si avvicinerebbe a questo uomo e si cercherebbe di fermano. Tenterebbe un primo uomo a fermarlo, proverebbe un secondo, un terzo, un quarto, ecc.: sino a immobilizzare completamente l’uomo che si muove.

Vediamo ora cosa avviene per la persona in contatto coll’uomo che si muove sempre. La persona che cercherà di fermarlo assorbirà una parte del suo movimento e così succederà alla seconda, alla terza, alla quarta persona, sino al completo assorbimento del movimento dell’uomo che si muove sempre, il quale, in tal modo, rimarrà fermo perché tutte quelle persone ne avranno assorbito il movimento.

E’ giusto quanto ho detto? Avviene così in pratica? Senza dubbio. Ebbene, io ho adottato lo stesso metodo per fermare l’atomo.

Prendiamo un gruppo di atomi, mettiamolo sotto un microscopio atomico e osserviamolo. Dopo un certo periodo di tempo gli atomi in osservazione scompaiono dai nostri occhi, giacché, eccitati dagli fotoni-luce .

Ciò perché gli fotoni-luce entrano in risonanza con gli atomi in osservazione, i quali, eccitati, scompaiono.

Da questa semplice osservazione si possono trarre quattro leggi fondamentali, e cioè:

1- Cessione in movimento – I fotoni-luce, con l’eccitare gli atomi in osservazione, cedono parte del loro movimento.

2- Assorbimento – Gli atomi in osservazione assorbono dai fotoni-luce parte del movimento di quest’ultimi per aumentare il proprio.

3- Attrazione. – Per poter eccitare un atomo occorre che questo venga in contatto con un altro atomo di maggior movimento; l’atomo che ha maggior movimento attiverà l’atomo di minor movimento.

4- Luminosità. – Quanto più l’atomo si muove, tanto più questo diventa luminoso e viceversa.

Constatate queste importanti proprietà dell’atomo, si potrebbe fare questo ragionamento: se il fotone-luce avesse, ad esempio, 600 di energia di movimento e l’atomo in osservazione avesse 400, quando l’atomo in osservazione scomparirà dai nostri occhi i due atomi avranno preso un movimento medio e cioè un movimento di Energia 600 + 400 cioè 1000 Questa sarà distribuita a due atomi riceventi ciascuno 500.

Calcolo che potrebbe essere esatto se non venisse contraddetto da una nuova osservazione. Esaminiamo bene gli atomi delle varie materie: constateremo che ogni atomo ha un assorbimento suo proprio. Non potremo quindi ottenere un movimento medio, bensì un movimento differente da ambo le parti.

In che modo ciò avviene? Ammettiamo che il fotone-luce abbia un movimento di 600 e l’atomo in osservazione abbia una disponibilità di assorbimento, ad esempio, di 350; non potrà mai quest’ultimo avere un movimento medio di 475 perché il suo assorbimento è solo di 350. (E’ il problema della quantizzazione)

Da quanto sopra, si può constatare che gli atomi hanno un assorbimento differente l’uno dall’altro a seconda della categoria della materia cui appartengono.

Conosciuti questi diversi assorbimenti, ho cercato di formare una scala di atomi di varie materie con assorbimenti, rispetto ai fotoni-luce da un massimo di 95% ad un minimo di 1%.

Spiegazione della scala atomica

Diamo, ad esempio, come base di unità 100 movimenti del fotone-luce , cerchiamo fra tutte le materie quella che ha un assorbimento del 95% rispetto a tale atomo e assegniamo a detta materia la categoria A.

Lo stesso facciamo per la materia con assorbimento del l’85% e continuiamo questo procedimento sino ad arrivare alla materia meno assorbente.

Mettiamo tutte queste materie una accanto all’altra: formeremo così una scala che avrà un assorbimento da un massimo di 95% ad un minimo di 1 %.

Per formare questa scala, date le varie numerosissime materie esistenti in natura, mi sono occorsi quattro anni.

Lasciamo, per ora, da parte questa scala che ci servirà al momento opportuno. Ritorniamo ad osservare gli atomi: vedremo che quelli in osservazione vengono disturbati, oltre che dai fotoni-luce, dagli atomi esterni. Per ovviare a questo inconveniente cerchiamo di eliminare anzitutto gli atomi esterni.

Facendo ancora un confronto con la nostra vita pratica, immaginiamo di vedere una partita di calcio e cerchiamo di eliminare i curiosi che stanno al di là del campo. Per ottenere ciò occorre circondare i giocatori con un muraglione e impedirne la loro vista.

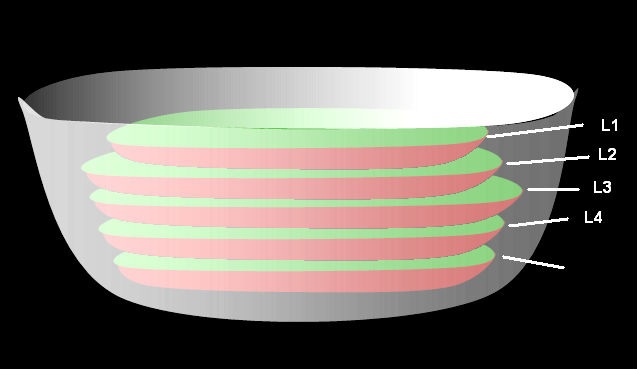

Così ho fatto con gli atomi esterni: ho formato uno spessore (muraglione) tra gli atomi in osservazione e gli atomi esterni adoperando la materia avente meno atomi assorbenti allo scopo di impedire l’eccitamento degli atomi stessi, e prelevando la materia dalla scala che avevo costruito.

Ma l’eccitamento degli atomi che attorniavano creando uno spessore si produceva ugualmente, perché contemporaneamente eccitati dagli atomi esterni sopratutto ma anche interni.

Ho allora formato uno strato interno ed uno esterno di materia composta di atomi con maggior assorbimento, ottenendo così una specie di impermeabilità e di isolamento degli atomi interni da quelli esterni. Rimosso questo primo inconveniente, ho procurato di rimediare al secondo, cioè l’eccitamento dei fotoni-luce sugli atomi in osservazione, inconveniente che, come ho detto sopra, li rende invisibili.

Eliminati però gli fotoni-luce, non potevo più scorgere quelli in osservazione, cioè quelli interni, perché anche la luce veniva a mancare. Unico mezzo mi parve quello di cercare di fermare gli atomi in osservazione. Come fare? La scala che avevo costruita mi venne in soccorso, ed ecco come.

Cerchiamo anzitutto di vedere come la scala funziona.

Se avviciniamo il massimo della scala ad un atomo in osservazione, noteremo che la scala verrà a formare come un piccolo canaletto di scarico, perchè l’atomo della scala con assorbimento 95% assorbirà il 95% del movimento dell’atomo in osservazione e l’atomo di assorbimento 85% assorbirà l’85% dell’atomo 95%, e così di seguito fino all’atomo di assorbimento 1% che assorbirà l’l% dell’atomo 2%. Si verrà in tal modo a formare, come ho detto, una specie di canaletto di scarico. Ora, se il movimento del fotone-luce è costante, per fermare l’atomo in osservazione si dovrà procedere nella stessa maniera supposta per poter fermare l’uomo che si muove sempre.

Quindi se un canaletto non è sufficiente, se ne metteranno due, tre, quattro, ecc. sino ad ottenere l’immobilità dell’atomo in osservazione. Praticamente ho introdotto il canaletto nello spessore, lasciando gli atomi con assorbimento 95% in contatto con gli atomi in osservazione, degradando gli assorbimenti fino a quelli con assorbimento minimo quasi alla fine dello spessore. I canaletti venivano così ad assorbire continuamente i movimenti degli atomi e l’osservazione veniva migliorata, lasciando intravedere le forme infinitamente piccole degli atomi stessi…..

Questo è tratto de uno scritto di Pierluigi Ighina è degli anni 50 non ebbe seguito, mancano verifiche esterne. Però potrebbe essere una base di partenza, un’intuizione o se volete una visione esoterica.

Comunque sia è un fatto acclarato anche in fisica che gli atomi assorbono energia che poi riemettono come luce, quindi è un’ipotesi che ha un suo valore.

Il punto di domanda si sposta però su come circondare il percorso superconduttore con atomi che non disturbino. Seguendo il discorso succitato occorrerebbe affiancare atomi opportuni lungo tutto il condotto superconduttivo: ma quali? Bisogna andare per tentativi.

Il primo strato potrebbe essere dato dal rame, poi atomi assorbitori di minor peso atomico…

Infine c’è da considerare l’agitazione intrinseca degli atomi che formano il percorso superconduttore. Forse però diventano superconduttori solo strutture in cui l’energia vibrazionale si allinea in modo da non disturbare il salto da un “sasso all’altro”.

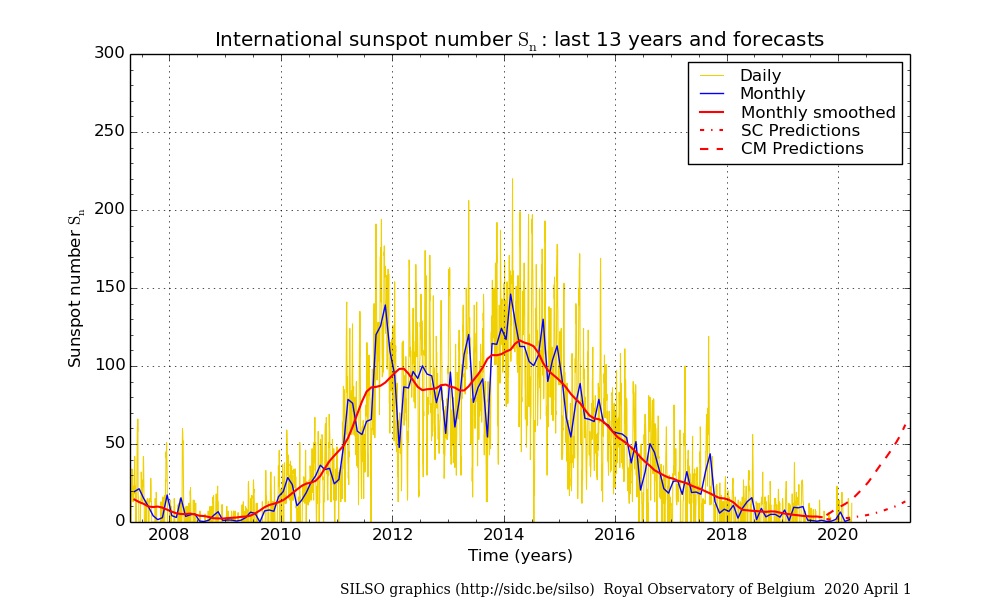

Purtroppo, il delirio tecnologico in cui viviamo non lascia alcuna possibilità di tornare a vedere il SOLE come la vera fonte della vita (ma qualcuno pensa persino di oscurarlo, utilizzando il pretesto dei cambiamenti climatici).

Purtroppo, il delirio tecnologico in cui viviamo non lascia alcuna possibilità di tornare a vedere il SOLE come la vera fonte della vita (ma qualcuno pensa persino di oscurarlo, utilizzando il pretesto dei cambiamenti climatici).